ב-12 ביוני, בשעה 9:01 בערב, התכוננה פייסבוק למתקפה הגדולה. כ-220 מיליון משתמשים היו לרשת החברתית באותו זמן, וכולם, או לפחות רבים מהם, היו עשויים להסתער בשעה המדוברת על אתר החברה כדי לבחור לעצמם שם משתמש נוח.

אחרי הכול, לא מעט ממשתמשי האתר רואים בו חלק מרכזי משגרת הפעילות שלהם באינטרנט, והגיוני שירצו "לתפוס" את השם הכי נוח שישולב בשורת הכתובת של האתר (URL), מה שעלול ליצור עומס ניכר על השרתים. החשש של החברה, כך סיפר שבועיים לאחר מכן ג'ונתן היליגר, סגן נשיא לתפעול טכני בפייסבוק, בכנס של הבלוג Giga Om, היה שהאתר ייתקע. "קראנו לפרויקט בשם 'פטיש' ('Hammer'), פשוט כי חששנו שזה יכה את האתר שלנו", הסביר היליגר.

היליגר אפשר לעצמו לדבר בכנות באותו כנס, אבל בין השורות אפשר היה להבחין במצוקה. הוא לא היסס למתוח ביקורת חריפה על ענקיות השבבים והחומרה, כגון אינטל, IBM ו-HP שאינן עומדות בציפיות. "חבר'ה אתם לא קולטים מה אתרים כגון פייסבוק או אמזון צריכים", פנה לנציגי חברות החומרה שישבו בקהל.

הדיון על תשתית החומרה של פייסבוק נראה כמעט לא רלוונטי למשתמשים הסטנדרטיים, שפוגשים את פייסבוק, גוגל, יאהו ואמזון רק באמצעות הממשק החיצוני והפשוט לשימוש. אך מתחת לדפי הבית המעוצבים מסתתר פס ייצור שלם ועתיר משאבים שתומך ביכולות האלו.

פייסבוק, לדוגמה, עמדה בשנה האחרונה בפני אחד האתגרים הגדולים ביותר בהיסטוריה העסקית - החברה הגדילה את היקף הפעילות שלה פי שלושה לערך, ל-400 מיליון משתמשים, בתוך פחות משנה. המשמעות של גידול אינטנסיבי שכזה בסדר הגודל של הפעילות כוללת הגדלה אדירה של הוצאות על ציוד מחשוב, על כוח אדם, על צריכת אנרגיה ועל קירור, שלא לדבר על דאגה תמידית לתמיכה בגידול העתידי.

פחות כאב ראש

אין פלא, אם כך, שהיליגר חש על בשרו היטב את הצורך במשאבי מחשוב שיתמכו בצמיחה שכזו. בינואר השנה חצתה פייסבוק את הקווים, והצטרפה לרשימה מתארכת והולכת של חברות האינטרנט הגדולות, ביניהן גוגל, יאהו, eBay ומיקרוסופט, שבונות את מרכזי המחשוב האדירים שלהן בעצמן.

"זה צעד חשוב בצמיחה שלנו", הסביר היליגר את המהלך בבלוג שהוא כותב, "חשוב שנוכל לתכנן את מרכז הנתונים עבור הצרכים הייחודים שלנו". לפייסבוק היו עד תחילת 2010 שלושה מרכזי נתונים ששכרה בארה"ב שהכילו, על פי הערכות, כ-30 אלף שרתים, נכון לסוף 2009. העלויות של שכירת השטח לבדן הוערכו על ידי datacenter ב-20-30 מיליון דולר בשנה, זאת מלבד הוצאות על רכישת אמצעי המחשוב, אנרגיה וקירור, שהוערכו בכמה עשרות מיליוני דולרים נוספים בשנה.

מרכז הנתונים החדש שמתכננת פייסבוק באורגון יחייב אמנם הוצאה גדולה בהרבה בהתחלה, אבל יחסוך הרבה כאבי ראש בעת גידול עתידי של היקפי הפעילות, וכן יאפשר לחברה לתכנן אותו כך שיצרוך הרבה פחות אנרגיה מחוות שרתים רגילה. את הגישה של בניית מרכז נתונים עצמאי למדה פייסבוק מגוגל, שעל-פי נתונים שהיא מספקת, מפעילה את חוות השרתים היעילה ביותר בעולם מבחינת צריכת אנרגיה, מה שכמובן מפחית בצורה ניכרת את ההוצאות שלה.

פייסבוק מציגה מספרים מרשימים בכל הקשור להיקפי המשתמשים והפעילות - היא מתמודדת כבר עתה עם יותר מ-200 מיליארד דפים בחודש ועם יותר מ-25 טרהבייט של מידע ליום (כאלף פעמים כמות הדואר שמועברת בכל יום בשירות הדואר של ארה"ב). אבל המספרים הללו עדיין מצומצמים יחסית. כאשר בפייסבוק מדברים על תיבת דואר אלקטרוני של כמה ג'יגה לכל משתמש (במקביל ל-Gmail), או על אפשרות להעלות תכני מולטימדיה בהיקפים גדולים בהרבה מכפי שקיימים היום, המשמעות היא תשתית מחשוב שיודעת לייעל עד למקסימום כל בייט של זיכרון ורוחב פס, והוצאות גבוהות על בניית תשתיות מחשוב מותאמות.

כמה עולה You-Tube

הדרישות הטכניות לתמיכה באתר עם תכני מולטימדיה (כגון סרטים, מוזיקה, תמונות וכדומה) הן פשוטות למדי. רוב האתרים הפרטיים - וגם של חברות בסדר גודל בינוני ואף יותר מזה - מתארחים על שרתים במרכזי המידע העצומים של ספקיות שירותי הטלקום, שיודעות לנהל עומסים.

אבל מה קורה, לדוגמה, באתר כמו יו-טיוב של גוגל? מה המשאבים שנדרשים כדי לעמוד בבקשות הגישה למחשבים שמחזיקים את התכנים באתר הזה?

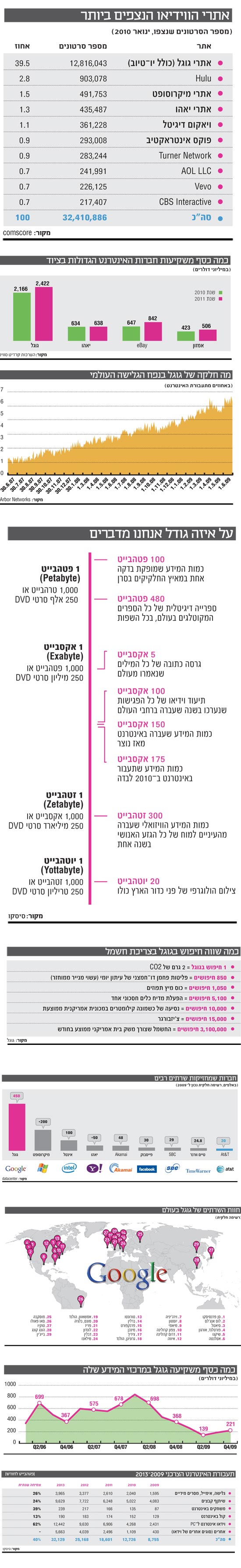

בואו נעשה חשבון. על-פי נתוני האתר comScore Video Metrix, כ-136 מיליון צופים אמריקנים ניגשו בינואר האחרון לאתר YouTube.com, שמספק כ-40% מתעבורת הווידאו און-ליין בארה"ב. הבא בתור דרך אגב, הוא האתר Hulu (שאינו פתוח לגלישה מישראל) עם 3% בלבד. בסך הכול, כ-500 מיליון צופים יש ליו-טיוב בעולם, ולפי הערכות, בשעות השיא נמצאים באתר כמה עשרות מיליונים בו-זמנית.

בבנק ההשקעות קרדיט סוויס ניסו לאחרונה לספק אומדן לסדר הגודל של ההשקעה הנדרשת כדי לספק את הביקושים האלו. בהנחה של 160 מיליון קטעי וידאו וממוצע של 35Mb לכל קטע, נדרשת הוצאה של כ-20 מיליון דולר בממוצע בשנת 2009 על עלויות החומרה לאחסון התכנים, פיתוח תוכנה מתאימה ואספקת חשמל. כסף קטן לחברה בסדר הגודל של גוגל.

אבל ההוצאה האמיתית מסתתרת בתעבורה, כלומר ביכולת לספק בו-זמנית, ללא השהיה, גישה לתוכן עבור משתמשים מארה"ב, מאירופה וממזרח אסיה. בקרדיט סוויס העריכו את העלות הזו ב-2009 ב-300 מיליון דולר, רק עבור אספקת רוחב הפס (קצב של 400Kb לשנייה) הנדרש ל-You Tube. לא כולם מסכימים עם הערכות אלו, בוודאי שלא גוגל, שהתשובה הרשמית שלה לשאלה כמה עולה אספקת התכנים היא: "פחות ממה שאתם חושבים".

ייתכן שזה באמת כך. גוגל הצליחה להפחית בשנת 2009 את ההוצאות ההוניות שלה על ציוד (CapEx) בכ-60%, ל-810 מיליון דולר. "גוגל מקימה בעצמה את מרכזי המידע המחשוב שלה ורוב הציוד מתוכנן ונבנה על ידנו", ניסה פטריק פיצ'טה (Patrick Pichette), סמנכ"ל הכספים של גוגל, להסביר בשיחת הוועידה לאחר פרסום הדו"ח הכספי לשנת 2009 את הסיבה לירידה בהוצאות, "מה שאתה צריך כדי להפחית עלויות זה לדחוף חזק את הגבולות ולעבוד קשה כדי להבטיח ביצועים טובים".

הטריק: סוללות בשרתים

ב-2009 נהנתה גוגל מההוצאה הגדולה על תשתיות המחשוב שביצעה בשנתיים הקודמות, ומכאן הירידה החדה בהוצאותיה. אבל באופן ממוצע, ההוצאות של גוגל על הפעילות במכרזי הנתונים הן בערך פי שלושה מאלו של יאהו, פי ארבעה משל eBay ופי שבעה משל אמזון.

הסיבות לכך נוגעות לא רק לסוג התכנים שמחזיקה גוגל על שרתיה, לצרכי התעבורה ולהיקפי הפעילות, אלא לגישה הכללית של ענקית החיפוש באינטרנט לנושא המחשוב. עד כמה שזה מפתיע, מבחינת התפקוד גוגל דומה יותר ליבמ מאשר למיקרוסופט, כלומר יש לה מנגנונים טכנולוגיים שמאפיינים חברת חומרה יותר מאשר חברת תוכנה.

גוגל בנתה את מאות אלפי השרתים המשמשים אותה בעצמה, תוך הסתמכות על ארכיטקטורת מחשוב שתוכננה על ידה. לפני שנה חשפה גוגל לראשונה את השרת הסטנדרטי שהיא משתמשת בו, ואחד הממצאים המפתיעים הוא שגוגל נעזרת בסוללה סטנדרטית של 12 וולט שמוצמדת לכל שרת כדי לספק זרם חשמלי במקרה של נפילת מתח, במקום מערכת UPS (מערכת גיבוי להפסקות חשמל). זה מאפשר לה יעילות בצריכת האנרגיה והקירור במרכזי הנתונים שלה.

דמיינו את התשתית של גוגל בתור נקודות על-גבי הגלובוס, שביניהן ישנו חיבור תקשורת מהיר במיוחד ותוכנה שיודעת, על-פי אלגוריתם, לאחסן ולשלוף נתונים לפי פרמטרים של שימושיות ומיקום גיאוגרפי, וכמובן לפי זמינות משאבי הזיכרון והעיבוד. למעשה, לגוגל יש מעין רשת העברת תוכן (CDN) משל עצמה (ראו מסגרת) סביב העולם. רק לשם הפרופורציות, גוגל, כך על פי הערכות של חברת Arbor Networks, הייתה אחראית ל-6%-10% מתעבורת האינטרנט בעולם בקיץ 2009 - מקביל לספקית האינטרנט השלישית בגודלה בעולם.

אף שגוגל היא חברה ציבורית, במשך השנים ניהלה החברה את התפעול השוטף שלה תחת מעטה סודיות כבד, וקשה מאוד לקבל את המספרים והנתונים המדויקים שעומדים מאחורי משאבי המחשוב שהיא מפעילה. ידוע שישנם כמה עשרות מרכזי מחשוב, כמעט בכל פינה ברחבי העולם (ובעיקר בארה"ב ואירופה, ראו מפה). בכל אחד ממרכזים אלה יש עשרות אלפי שרתים שאמורים לספק את הדרישות הגבוהות של גוגל בתשובה לשאילתות חיפוש, לאחסנת תכנים, לגיבויים ולמהירות גישה.

הסטנדרט הזה - פחות משנייה לקבלת תשובה על שאילתת חיפוש - הוא מטרה שהציבו המייסדים סרגיי ברין ולארי פייג' מרגע הקמת החברה. כדי לעמוד בזה, נעזרת גוגל, כך על פי הערכות, בחברת מלאנוקס הישראלית, ממנה היא מקבלת שבבים וכרטיסי תקשורת שמאפשרים תקשורת מהירה בתוך מרכזי הנתונים של החברה.

האינטרנט צומח במהירות

תעבורת ה-IP העולמית תגדל פי חמישה בין 2008 ל-2013 (קצב גידול שנתי של 40%).

ב-2013, האינטרנט יהיה כמעט פי ארבעה גדול יותר מאשר ב-2009. עד סוף 2013, המקבילה של 10 מיליארד סרטי DVD תעבור באינטרנט בכל חודש.

נפח תעבורת ה-IP השנתית יגיע ליותר משני שלישים של זטהבייט (667 אקסבייט) בתוך ארבע שנים. 510 אקסבייט לשנה בשנת 2012, 667 אקסבייט בשנת 2013.

רשתות שיתוף קבצים P2P נושאות כרגע 3.3 אקסבייט בחודש, וימשיכו לגדול בקצב צנוע של 18% לשנה מ-2008 עד 2013. צורות אחרות של שיתוף קבצים, כמו one-click file hosting, יגדלו במהירות גדולה יותר, של 58% לשנה, ויגיעו ל-3.2 אקסבייט בחודש בשנת 2013.

סכום כל הצורות של הווידיאו (טלוויזיה, וידאו לפי דרישה, אינטרנט ו-P2P) יגיע ל-91% מכל תעבורת הגולשים הצרכנית עד 2013. הווידאו לבד יהווה 60% מזה.

ייידרשו הרבה יותר מחצי מיליון שנים לצפות בכל האונליין וידאו שיעבור באינטרנט בכל חודש ב-2013.

VOD יכפיל את עצמו בכל שנתיים עד 2013. תעבורת ה-IPTV וה-CATV של הגולשים תגדל ב-53% בשנה בין 2008 ל-2013, בהשוואה לצמיחה שנתית של 40% בתעבורת האינטרנט כולה.

בכל העולם, תנועת המידע במכשירים הניידים תכפיל את עצמה בכל שנה עד 2013, ותגיע ליותר מ-2 אקסבייט בחודש עד 2013.

כמעט 64% מתנועת המידע הנייד בעולם תהיה של וידיאו עד 2013.

"תנועת הנתונים עולה ב-130% בשנה"

רשתות העברת התוכן (CDN) מלוות את ה-Web כמעט מאז יומה הראשון. בבסיס הטכנולוגיה עומד הרעיון שהרבה משתמשים ניגשים לאותו תוכן יותר מפעם אחת. אם כך, מדוע לא לאחסן את מה שאפשר על שרתים מקומיים, של ספקית שירות גישה לאינטרנט שאליה יש חיבור מהיר יחסית, ולמנוע את התנועה סביב העולם של תכנים "כבדים" כגון תמונות/סרטים/קול או קבצים גדולים?

מאז סוף שנות ה-90 פועלות חברות שונות שמתמחות בפתרונות מעין אלו, שמבוססים בעיקר על אלגוריתם לניהול זיכרון, על אופטימיזציה של תקשורת ועל דחיסת הנתונים. בינתיים השתנו התכנים ורוחבי הפס, והיום צריך לדאוג להעברה של וידיאו אונליין, וגם הפתרונות התקדמו. את הטכנולוגיות מספקות היום לא רק חברות ייעודיות אלא מספר רב של ספקיות ציוד התקשורת בעולם.

"העלייה בצריכה של הנתונים ברשת היא של 130% לשנה", טוען שי גרסטנר, המנהל הטכנולוגי של פעילות אלקטל לוסנט בישראל והנציג המקומי של מעבדות בל. "התעבורה של היום מבוססת יותר על יישומים ופחות על דפדפנים שמציגים תכנים ולכן יותר כבדה". העמידה בביצועים הנדרשים על ידי אתרי התוכן הגדולים, מעריך גרסטנר, כוללת כמה שיותר חוות שרתים, לצד ניהול עומסים משוכלל ככל האפשר.

בגוגל, לדוגמה, משתמשים במגוון דרכים כדי לשנע את התכנים מסביב לעולם מהר מספיק. חברות כמו אקמאי או Limelight מספקות שירותים לחברות אחרות, ואילו גוגל מפתחת ובונה פתרונות משלה - ביניהם אלגוריתם שיודע ללמוד את הדרישות והצרכים של המשתמשים. למעשה, גוגל מפתחת את הטכנולוגיות האלו בשביל התכנים שלה עצמה.

11